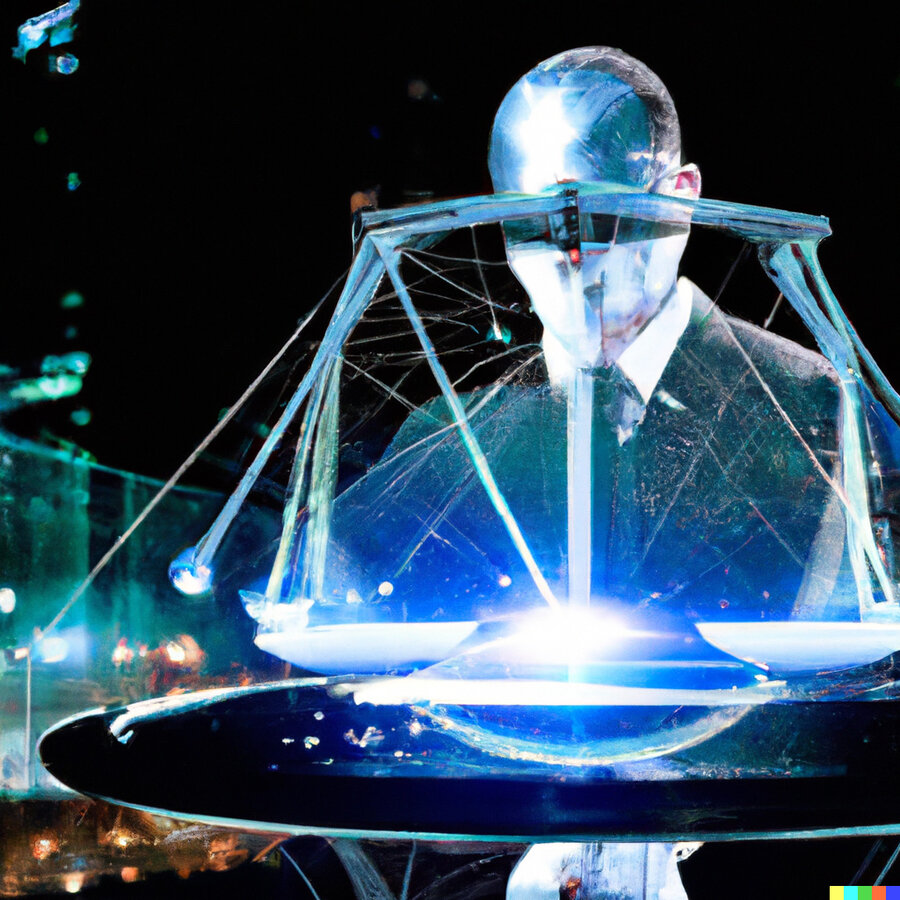

La Suprema Corte avanza con “cautela” y atenta a definiciones regionales en el desafío de regular la inteligencia artificial

Expertos sostienen que el avance tecnológico pone en cuestión las pruebas documentales como los audios y las fotos; la Cumbre Judicial Iberoamericana empieza a explorar su incorporación como herramienta de asistencia pero no para fallos finales o tareas sin supervisión

escribe Macarena Saavedra

Hay estudios de abogacía en Estados Unidos que trabajan con robots que asesoran en los casos. En Colombia, se realizó una audiencia en el metaverso y los jueces ya han tomado resoluciones con la ayuda del Chat GPT. En Estonia, se utiliza un sistema de inteligencia artificial para ayudar a dictar sentencias en casos de bajos montos económicos, casi sin intervención humana.

Esta nota es exclusiva para suscriptores de BÚSQUEDA y GALERÍA

Elegí tu plan y suscribite

¿Ya sos suscriptor? Iniciá sesión

Probá nuestro servicio, registrate y accedé a una nota gratuita por semana.